6.3: Оператор кондиціонування

- Page ID

- 90535

| Класичне кондиціонування | Оператор Кондиціонер | |

|---|---|---|

| Підхід до кондиціонування | Безумовний подразник (наприклад, їжа) поєднується з нейтральним подразником (таким як дзвіночок). Нейтральний подразник в кінцевому підсумку стає умовним подразником, який викликає умовну відповідь (слиновиділення). | Цільова поведінка супроводжується підкріпленням або покаранням, щоб або посилити, або послабити його, щоб учень мав більше шансів проявити бажану поведінку в майбутньому. |

| Стимул терміни | Подразник виникає безпосередньо перед відповідною реакцією. | Стимул (або підкріплення, або покарання) відбувається незабаром після відповіді. |

Психолог Б.Ф. Скіннер побачив, що класичне кондиціонування обмежується існуючою поведінкою, яка рефлекторно викликається, і це не враховує нових способів поведінки, таких як їзда на велосипеді. Він запропонував теорію про те, як відбувається така поведінка. Скіннер вважав, що поведінка мотивована наслідками, які ми отримуємо за поведінку: підкріпленнями і покараннями. Його ідея про те, що навчання є результатом наслідків, базується на законі ефекту, який вперше запропонував психолог Едвард Торндайк. Відповідно до закону ефекту, поведінка, за якою слідують наслідки, які задовольняють організм, частіше повторюється, а поведінка, за якою слідують неприємні наслідки, рідше повторюється (Thorndike, 1911). По суті, якщо організм робить щось, що приносить бажаний результат, організм, швидше за все, зробить це знову. Якщо організм робить щось, що не приносить бажаного результату, організм рідше робить це знову. Приклад закону дії - в працевлаштуванні. Однією з причин (і часто основною причиною) ми з'являємося на роботі, є те, що нам платять за це. Якщо ми перестанемо отримувати зарплату, ми, швидше за все, перестанемо з'являтися - навіть якщо ми любимо свою роботу.

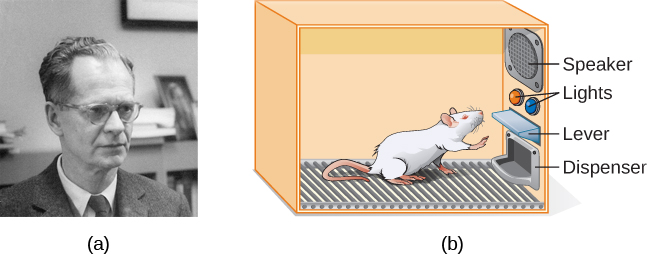

Працюючи з законом дії Торндайка як його фундамент, Скіннер почав проводити наукові експерименти над тваринами (головним чином щурами та голубами), щоб визначити, як організми навчаються через оперантне кондиціонування (Skinner, 1938). Він помістив цих тварин всередині оперантної камери кондиціонування, яка стала відомою як «коробка Скіннера» (рис. 6.10). Коробка Skinner містить важіль (для щурів) або диск (для голубів), який тварина може натиснути або клювати за харчову винагороду через дозатор. Динаміки та ліхтарі можуть бути пов'язані з певною поведінкою. Рекордер підраховує кількість відповідей, зроблених твариною.

| Позитивне та негативне підкріплення та покарання | ||

|---|---|---|

| Армування | Покарання | |

| Позитивні | Щось додається, щоб збільшити ймовірність поведінки. | Щось додається, щоб зменшити ймовірність поведінки. |

| Негативний | Щось видаляється, щоб збільшити ймовірність поведінки. | Щось видаляється, щоб зменшити ймовірність поведінки. |

Армування

Найефективніший спосіб навчити людину або тварину новій поведінці - з позитивним підкріпленням. У позитивному підкріпленні додається бажаний стимул для збільшення поведінки.

Наприклад, ви говорите своєму п'ятирічному синові Джерому, що якщо він прибере свою кімнату, то отримає іграшку. Джером швидко прибирає свою кімнату, тому що хоче новий художній набір. Давайте зробимо паузу на мить. Деякі люди можуть сказати: «Чому я повинен винагороджувати свою дитину за те, що вона робить те, що очікується?» Але насправді ми постійно і послідовно винагороджуємося в своєму житті. Наші зарплати - це винагороди, як і високі оцінки та прийняття до нашої улюбленої школи. Хвалити за хорошу роботу і за проходження водійського тесту - це теж нагорода. Позитивне підкріплення як інструмент навчання є надзвичайно ефективним. Встановлено, що одним із найефективніших способів підвищення успішності в шкільних округах з балами читання нижче середнього була оплата дітям за читання. Зокрема, учням другого класу в Далласі платили $2 кожен раз, коли вони читали книгу і пройшли коротку вікторину про книгу. Результатом стало значне збільшення розуміння читання (Fryer, 2010). Що ви думаєте про цю програму? Якби Скіннер був живий сьогодні, він, мабуть, подумав би, що це чудова ідея. Він був сильним прихильником використання оперантних принципів кондиціонування для впливу на поведінку учнів у школі. Насправді, окрім коробки Скіннера, він також винайшов те, що він назвав навчальною машиною, яка була розроблена для винагороди невеликих кроків у навчанні (Скіннер, 1961) - ранній предтеча комп'ютерного навчання. Його навчальна машина перевіряла знання учнів, коли вони працювали над різними шкільними предметами. Якщо студенти відповіли на питання правильно, вони отримали негайне позитивне підкріплення і могли продовжити; якщо вони відповіли неправильно, вони не отримали жодного підкріплення. Ідея полягала в тому, що студенти витратять додатковий час на вивчення матеріалу, щоб збільшити свої шанси на посилення наступного разу (Skinner, 1961).

При негативному підкріпленні знімається небажаний подразник для посилення поведінки. Наприклад, виробники автомобілів використовують принципи негативного посилення в своїх системах ременів безпеки, які йдуть «звуковий сигнал, звуковий сигнал, звуковий сигнал», поки ви не пристебнете ремінь безпеки. Дратівливий звук припиняється, коли ви проявляєте бажану поведінку, збільшуючи ймовірність того, що ви пристебнете в майбутньому. Негативне підкріплення також часто використовується в дресируванні коней. Вершники застосовують тиск - витягуючи поводи або стискаючи ноги - а потім знімають тиск, коли кінь виконує бажану поведінку, наприклад, поворот або прискорення. Тиск - це негативний стимул, який кінь хоче зняти.

Покарання

Багато людей плутають негативне підкріплення з покаранням в оперантному кондиціонуванні, але вони є двома дуже різними механізмами. Пам'ятайте, що підкріплення, навіть коли воно негативне, завжди збільшує поведінку. На відміну від цього, покарання завжди зменшує поведінку. У позитивне покарання ви додаєте небажаний стимул для зменшення поведінки. Прикладом позитивного покарання є лаяти учня, щоб змусити учня припинити текстові повідомлення в класі. У цьому випадку додається стимул (догану) для того, щоб зменшити поведінку (текстові повідомлення в класі). При негативному покаранні ви знімаєте приємний стимул до зниження поведінки. Наприклад, коли дитина погано себе веде, батько може забрати улюблену іграшку. В цьому випадку знімається подразник (іграшка) з метою зниження поведінки.

Покарання, особливо коли воно негайне, є одним із способів зменшити небажану поведінку. Наприклад, уявіть, що ваш чотирирічний син Брендон вдарив молодшого брата. У вас Брендон написати 100 разів «Я брата не вдарить» (позитивне покарання). Швидше за все, він не повторить таку поведінку. Хоча подібні стратегії сьогодні поширені, в минулому діти часто піддавалися фізичному покаранню, наприклад, порці. Важливо знати про деякі недоліки використання фізичних покарань на дітей. По-перше, покарання може навчити страху. Брендон може боятися вулиці, але він також може боятися людини, яка доставила покарання - ви, його батько. Так само діти, яких покарають вчителі, можуть прийти побоюватися вчителя і намагатися уникати школи (Gershoff et al., 2010). Отже, більшість шкіл у Сполучених Штатах заборонили тілесні покарання. По-друге, покарання може призвести до того, що діти стануть більш агресивними і схильними до асоціальної поведінки та правопорушень (Gershoff, 2002). Вони бачать, як їхні батьки вдаються до порки, коли вони сердяться і розчаруються, тому, в свою чергу, вони можуть діяти таку саму поведінку, коли вони зляться і розчаруються. Наприклад, тому що ви шльопати Бренда, коли ви сердитеся на неї за її неправильну поведінку, вона може почати бити своїх друзів, коли вони не поділяться своїми іграшками.

Хоча позитивне покарання може бути ефективним у деяких випадках, Скіннер припустив, що використання покарання слід зважити з можливими негативними наслідками. Сьогоднішні психологи та експерти з виховання дітей виступають за підкріплення покарання—вони рекомендують зловити дитину, роблячи щось хороше, і винагородити її за це.

Шейпінг

У своїх оперантних експериментах кондиціонування Скіннер часто використовував підхід, який називається формуванням. Замість того, щоб винагороджувати лише цільову поведінку, у формуванні ми винагороджуємо послідовні наближення цільової поведінки. Навіщо потрібен шейпінг? Пам'ятайте, що для того, щоб підкріплення спрацювало, організм повинен спочатку проявити поведінку. Формування необхідне, тому що вкрай малоймовірно, що організм буде демонструвати що-небудь, крім найпростішої поведінки спонтанно. У формуванні поведінка розбивається на безліч дрібних, досяжних кроків. Конкретні етапи, що використовуються в процесі, такі:

Формування часто використовується при навчанні складної поведінки або ланцюга поведінки. Скіннер використовував формування, щоб навчити голубів не тільки такої відносно простої поведінки, як клювання диска в скриньері Скіннера, але і багатьох незвичайних і розважальних способів поведінки, таких як поворот в колах, ходьба по вісімках і навіть гра в пінг-понг; техніка сьогодні зазвичай використовується тренерами тварин. Важливою частиною формування є дискримінація стимулів. Згадайте собак Павлова—він навчив їх реагувати на тон дзвіночка, а не на схожі тони або звуки. Ця дискримінація також важлива в оперантному обумовленні та формуванні поведінки.

Легко зрозуміти, наскільки шейпінг ефективний у навчанні поведінки тварин, але як шейпінг працює з людьми? Розглянемо батьків, чия мета полягає в тому, щоб їхня дитина навчилася прибирати свою кімнату. Вони використовують формування, щоб допомогти йому освоїти кроки до мети. Замість того, щоб виконувати все завдання, вони налаштовують ці кроки і підсилюють кожен крок. Спочатку він прибирає одну іграшку. По-друге, він прибирає п'ять іграшок. По-третє, він вибирає, чи взяти десять іграшок або відкласти свої книги та одяг подалі. По-четверте, він прибирає все, крім двох іграшок. Нарешті, він очищає всю свою кімнату.

Первинні та вторинні підсилювачі

Такі нагороди, як наклейки, похвала, гроші, іграшки тощо, можуть бути використані для посилення навчання. Повернемося до щурів Скіннера знову. Як щури навчилися натискати важіль в ящику Скіннера? Їх нагороджували їжею кожен раз, коли вони натискали на важіль. Для тварин їжа була б очевидним підсилювачем.

Що було б хорошим підсилювачем для людини? Для вашої дитини Кріса це була обіцянка іграшки, коли вони прибирали свою кімнату. Як щодо Сіднея, футболіста? Якби ви дали Сіднею шматок цукерок кожен раз, коли Сідней забив гол, ви б використовувати основний підсилювач. Первинні арматури - це арматури, що володіють вродженими зміцнюючими якостями. Ці види арматури не вивчені. Вода, їжа, сон, притулок, секс та дотик, серед іншого, є основними підсилювачами. Задоволення також є первинним підсилювачем. Організми не втрачають свого потягу до цих речей. Для більшості людей стрибки в прохолодному озері в дуже спекотний день зміцнювали б, а прохолодне озеро було б вродженим посиленням - вода охолоджувала б людину (фізична потреба), а також забезпечить задоволення.

Вторинний підсилювач не має властивої цінності і має лише зміцнюючі якості, коли він пов'язаний з первинним підсилювачем. Похвала, пов'язана з прихильністю, є одним із прикладів вторинного підсилювача, як коли ви називали «Великий постріл!» кожен раз, коли Сідней робив гол. Інший приклад, гроші, коштують чогось лише тоді, коли ви можете використовувати їх для придбання інших речей - або речей, які задовольняють основні потреби (їжа, вода, укриття - всі первинні підсилювачі) або інші вторинні підсилювачі. Якби ви були на віддаленому острові посеред Тихого океану і у вас були купи грошей, гроші не були б корисними, якби ви не змогли їх витратити. А як щодо наклейок на діаграмі поведінки? Вони також є вторинними армувальниками.

Іноді замість наклейок на діаграмі наклейок використовується маркер. Токени, які також є вторинними підсилювачами, потім можна торгувати на винагороди та призи. Цілі системи управління поведінкою, відомі як економіка токенів, побудовані на основі використання цих видів підсилювачів токенів. Виявлено, що економіка маркерів дуже ефективна при зміні поведінки в різних умовах, таких як школи, в'язниці та психіатричні лікарні. Наприклад, дослідження Кангі та Дейлі (2013) показало, що використання маркерної економіки збільшило відповідну соціальну поведінку та зменшило невідповідну поведінку в групі школярів з аутизмом. Діти з аутизмом, як правило, виявляють руйнівну поведінку, таку як защемлення та удари. Коли діти в дослідженні виявляли відповідну поведінку (не вдаряючись і не пощипуючи), вони отримали знак «тихих рук». Коли вони вдарили або щипали, вони втратили жетон. Потім діти могли обміняти вказану кількість жетонів на хвилини ігрового часу.

Тайм-аут - ще одна популярна методика, яка використовується в модифікації поведінки з дітьми. Діє за принципом негативного покарання. Коли дитина демонструє небажану поведінку, її відстороняють від бажаної діяльності під рукою (рис. 6.12). Наприклад, скажіть, що Софія і її брат Маріо грають з будівельними блоками. Софія кидає кілька блоків на свого брата, тому ви даєте їй попередження, що вона піде на тайм-аут, якщо вона зробить це знову. Через кілька хвилин вона кидає більше блоків на Маріо. Ви прибираєте Софію з кімнати на кілька хвилин. Коли вона повертається, вона не кидає блоки.

Є кілька важливих моментів, які ви повинні знати, якщо ви плануєте реалізувати тайм-аут як техніку модифікації поведінки. По-перше, переконайтеся, що дитину видаляють з бажаної діяльності та розміщують у менш бажаному місці. Якщо діяльність є чимось небажаним для дитини, ця техніка призведе до зворотного результату, оскільки дитині приємніше бути відстороненою від діяльності. По-друге, важлива тривалість тайм-ауту. Загальне емпіричне правило - одна хвилина на кожен рік віку дитини. Софії п'ять, тому вона сидить у тайм-ауті п'ять хвилин. Встановлення таймера допомагає дітям знати, як довго вони повинні сидіти в тайм-ауті. Нарешті, як вихователь, майте на увазі кілька вказівок протягом тайм-ауту: зберігайте спокій, направляючи дитину на тайм-аут; ігноруйте дитину під час тайм-ауту (оскільки увага вихователя може посилити неправильну поведінку); і дайте дитині обійняти або добре слово, коли тайм-аут закінчиться.

Графіки армування

Пам'ятайте, найкращий спосіб навчити людину чи тварину поведінці - використовувати позитивне підкріплення. Наприклад, Скіннер використовував позитивне підкріплення, щоб навчити щурів натискати важіль у коробці Скіннера. Спочатку щур може випадковим чином вдарити важіль, досліджуючи коробку, і вийде гранула з їжею. З'ївши гранули, що, на вашу думку, зробила голодна щур далі? Він знову вдарив важіль, і отримав ще одну гранулу їжі. Кожен раз, коли щур вдаряла в важіль, виходила гранула з їжею. Коли організм отримує підсилювач кожного разу, коли він проявляє поведінку, це називається безперервним підкріпленням. Цей графік підкріплення - найшвидший спосіб навчити когось поведінці, і він особливо ефективний у навчанні нової поведінки. Давайте подивимося назад на собаку, яка вчилася сидіти раніше в розділі. Тепер кожен раз, коли він сидить, ви даєте йому ласощі. Тут важливі терміни: ви будете найбільш успішними, якщо представите підкріплювача відразу після того, як він сидить, щоб він міг скласти асоціацію між цільовою поведінкою (сидячи) і наслідком (отримання частування).

| Графіки армування | |||

|---|---|---|---|

| Графік армування | Опис | Результат | Приклад |

| Фіксований інтервал | Армування доставляється через передбачувані проміжки часу (наприклад, через 5, 10, 15 і 20 хвилин). | Помірна швидкість реакції зі значними паузами після підкріплення | Пацієнт лікарні використовує пацієнт-контрольоване, призначене лікарем для полегшення болю |

| Змінний інтервал | Армування доставляється через непередбачувані проміжки часу (наприклад, через 5, 7, 10 і 20 хвилин). | Помірна, але стабільна швидкість відгуку | Перевірка Фейсбук |

| Фіксований коефіцієнт | Підкріплення доставляється після передбачуваної кількості відповідей (наприклад, після 2, 4, 6 та 8 відповідей). | Висока швидкість реакції з паузами після армування | Відрядна - заводський працівник отримує оплату за кожне x кількість вироблених виробів |

| Змінне співвідношення | Підкріплення доставляється після непередбачуваної кількості відповідей (наприклад, після 1, 4, 5 та 9 відповідей). | Висока і стабільна швидкість відгуку | Азартні ігри |

Тепер давайте об'єднаємо ці чотири терміни. Графік підкріплення фіксованого інтервалу - це коли поведінка винагороджується через встановлений проміжок часу. Наприклад, червень проходить велику операцію в стаціонарі. Під час одужання вона, як очікується, відчує біль і вимагатиме рецептурних препаратів для зняття болю. У червні вводять в/в крапельницю з болезаспокійливим засобом, контрольованим пацієнтом. Її лікар встановлює межу: одна доза на годину. Червень натискає кнопку, коли біль стає важкою, і вона отримує дозу ліків. Оскільки винагорода (полегшення болю) відбувається лише з фіксованим інтервалом, немає сенсу проявляти поведінку, коли вона не буде винагороджена.

За допомогою графіка підкріплення змінного інтервалу людина або тварина отримує підкріплення на основі різної кількості часу, які є непередбачуваними. Скажіть, що Мануель є менеджером у ресторані швидкого харчування. Кожного разу хтось із відділу контролю якості приходить до ресторану Мануеля. Якщо ресторан чистий і обслуговування швидке, кожен на цій зміні заробляє бонус у розмірі 20 доларів. Мануель ніколи не знає, коли з'явиться людина з контролю якості, тому він завжди намагається підтримувати ресторан в чистоті та гарантує, що його співробітники забезпечують швидке та ввічливе обслуговування. Його продуктивність щодо швидкого обслуговування та підтримання чистого ресторану стійкі, тому що він хоче, щоб його екіпаж заробив бонус.

За допомогою графіка посилення фіксованого коефіцієнта існує встановлена кількість відповідей, які повинні відбутися, перш ніж поведінка буде винагороджена. Карла продає окуляри в магазині окулярів, і вона заробляє комісію кожного разу, коли продає пару окулярів. Вона завжди намагається продати людям більше пар окулярів, включаючи сонцезахисні окуляри за рецептом або резервну пару, щоб вона могла збільшити свою комісію. Їй байдуже, якщо людині дійсно потрібні сонцезахисні окуляри за рецептом, Карла просто хоче її бонус. Якість того, що продає Карла, не має значення, оскільки її комісія не базується на якості; вона базується лише на кількості проданих пар. Ця відмінність в якості виконання може допомогти визначити, який метод армування найбільш підходить для конкретної ситуації. Фіксовані коефіцієнти краще підходять для оптимізації кількості продукції, тоді як фіксований інтервал, в якому винагорода не базується на кількості, може призвести до більш високої якості випуску.

У графіку посилення змінного коефіцієнта кількість відповідей, необхідних для винагороди, змінюється. Це найпотужніший графік часткового підкріплення. Прикладом графіка посилення змінного коефіцієнта є азартні ігри. Уявіть собі, що Сара - як правило, розумна, ощадлива жінка - вперше відвідує Лас-Вегас. Вона не азартна людина, але з цікавості кладе чверть в ігровий автомат, а потім ще, і інше. Нічого не відбувається. Два долари в кварталах пізніше, її цікавість згасає, і вона ось-ось кине. Але потім, машина загоряється, дзвони зникають, і Сара отримує 50 кварталів назад. Це більше схоже на це! Сара повертається до вставки кварталів з оновленим інтересом, і через кілька хвилин вона використала всі свої прибутки і становить 10 доларів у дірці. Тепер може бути розумний час, щоб кинути палити. І все ж, вона продовжує вкладати гроші в ігровий автомат, тому що вона ніколи не знає, коли йде наступне підкріплення. Вона продовжує думати, що з наступного кварталу вона може виграти $50, або $100, або навіть більше. Оскільки графік підкріплення в більшості видів азартних ігор має графік змінного співвідношення, люди продовжують намагатися і сподіватися, що наступного разу вони виграють великий. Це одна з причин того, що азартні ігри настільки залежні і настільки стійкі до вимирання.

При оперантному кондиціонуванні згасання посиленої поведінки відбувається в якийсь момент після зупинки армування, і швидкість, з якою це відбувається, залежить від графіка армування. У графіку змінного співвідношення точка згасання настає дуже повільно, як описано вище. Але в інших графіках підкріплення згасання може настати швидко. Наприклад, якщо червень натискає кнопку для знеболюючого препарату до відведеного часу, який затвердив її лікар, ліки не вводяться. Вона знаходиться на фіксованому інтервальному графіку армування (дозовано щогодини), тому згасання відбувається швидко, коли підкріплення не настає в очікуваний час. Серед графіків армування змінне співвідношення є найбільш продуктивним і найбільш стійким до вимирання. Фіксований інтервал є найменш продуктивним і найпростішим для гасіння (рис. 6.13).

Скіннер (1953) заявив: «Якщо гральний заклад не може переконати мецената повернути гроші без повернення, він може досягти того ж ефекту, повернувши частину грошей покровителя за графіком зі змінним співвідношенням» (стор. 397).

Скіннер використовує азартні ігри як приклад сили графіка посилення змінного співвідношення для підтримки поведінки навіть протягом тривалих періодів без будь-якого підкріплення. Насправді Скіннер був настільки впевнений у своїх знаннях про азартну залежність, що навіть стверджував, що може перетворити голуба на патологічного гравця («Утопія Скіннера», 1971). Це дійсно правда, що графіки зі змінним співвідношенням зберігають поведінку досить наполегливою - просто уявіть частоту істерик дитини, якщо батько навіть один раз піддається поведінці. Випадкова нагорода робить майже неможливим зупинити поведінку.

Останні дослідження на щурах не змогли підтримати ідею Скіннера про те, що навчання лише за графіками змінного співвідношення спричиняє патологічні азартні ігри (Laskowski et al., 2019). Однак інші дослідження показують, що азартні ігри, здається, працюють на мозку так само, як і більшість наркотиків, що викликають звикання, і тому може існувати деяка комбінація хімії мозку та графіка підкріплення, які можуть призвести до проблеми азартних ігор (рис. 6.14). Зокрема, сучасні дослідження показують зв'язок між азартними іграми та активацією центрів винагороди мозку, які використовують нейромедіатор (хімічний мозок) дофамін (Murch & Clark, 2016). Цікаво, що гравцям навіть не потрібно перемагати, щоб випробувати «прилив» дофаміну в мозку. Також було показано, що «Близькі промахи» або майже виграшні, але насправді не виграють, також збільшують активність у вентральній стріатумі та інших центрах винагороди мозку, які використовують дофамін (Chase & Clark, 2010). Ці ефекти мозку майже ідентичні тим, що виробляються наркотиками, що викликають звикання, такі як кокаїн та героїн (Murch & Clark, 2016). На основі нейронаукових даних, що показують ці подібності, DSM-5 тепер вважає азартні ігри залежністю, тоді як попередні версії DSM класифікували азартні ігри як розлад контролю імпульсів.

Окрім дофаміну, азартні ігри також включають інші нейромедіатори, включаючи норадреналін та серотонін (Potenza, 2013). Норадреналін виділяється, коли людина відчуває стрес, збудження або гострі відчуття. Можливо, патологічні гравці використовують азартні ігри для підвищення рівня цього нейромедіатора. Недоліки серотоніну також можуть сприяти нав'язливій поведінці, включаючи залежність від азартних ігор (Potenza, 2013).

Можливо, патологічний мозок гравців відрізняється від мозку інших людей, і, можливо, ця різниця може якось призвести до їхньої залежності від азартних ігор, як, здається, припускають ці дослідження. Однак з'ясувати причину дуже складно, оскільки неможливо провести справжній експеримент (було б неетично намагатися перетворити випадково призначених учасників в проблемних гравців). Тому може бути, що причинно-наслідковий зв'язок фактично рухається в протилежному напрямку - можливо, акт азартних ігор якимось чином змінює рівень нейромедіаторів у мозку деяких гравців. Можливо також, що якийсь непомічений фактор, або заплутаний змінний, зіграв певну роль як в залежності від азартних ігор, так і відмінності в хімії мозку.

Пізнання та латентне навчання

Суворі біхевіористи, такі як Ватсон і Скіннер, зосередилися виключно на вивченні поведінки, а не на пізнанні (таких як думки та очікування). Насправді Скіннер був настільки стійким віруючим, що пізнання не мало значення, що його ідеї вважалися радикальним біхевіоризмом. Скіннер вважав розум «чорною скринькою» - чимось абсолютно непізнаваним - і, отже, щось не слід вивчати. Однак інший біхевіорист, Едвард Толман, мав іншу думку. Експерименти Толмана з щурами продемонстрували, що організми можуть вчитися, навіть якщо вони не отримують негайного підкріплення (Tolman & Honzik, 1930; Tolman, Ritchie, & Kalish, 1946). Цей висновок конфліктував з переважаючою ідеєю в той час, що підкріплення повинно бути негайним для того, щоб навчання відбулося, тим самим пропонуючи пізнавальний аспект навчання.

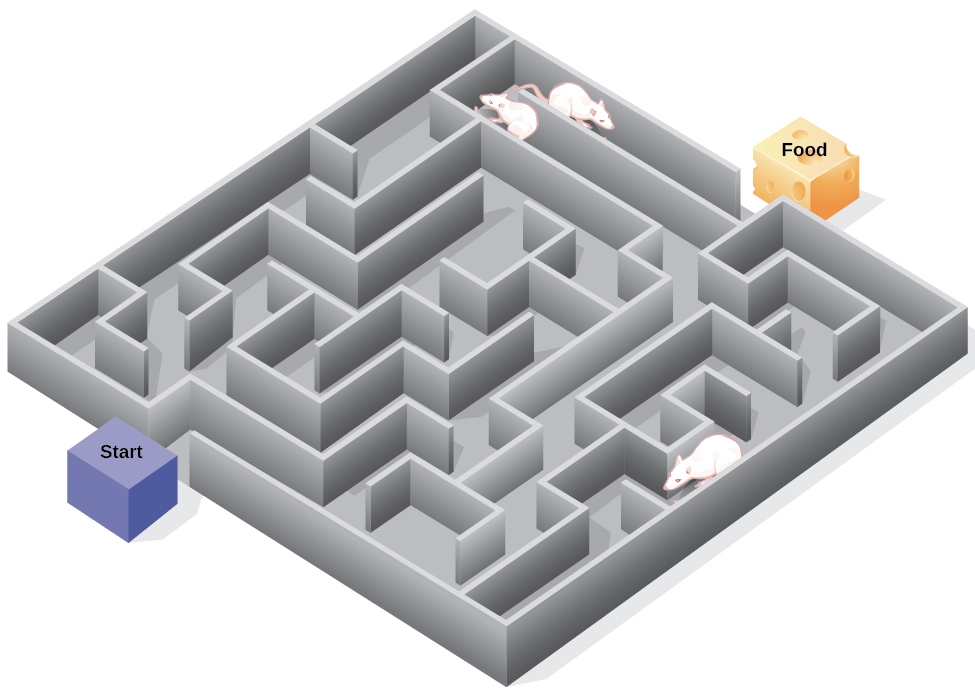

В експериментах Толман поміщав голодних щурів в лабіринт без винагороди за те, що вони знайшли свій шлях через нього. Він також вивчав групу порівняння, яка була винагороджена їжею в кінці лабіринту. Коли неармовані щури досліджували лабіринт, вони розробили пізнавальну карту: ментальну картину планування лабіринту (рис. 6.15). Після 10 сеансів в лабіринті без підкріплення їжа була поміщена в ящик воріт в кінці лабіринту. Як тільки щури дізналися про їжу, вони змогли швидко знайти свій шлях через лабіринт, так само швидко, як і група порівняння, яка була винагороджена їжею весь час. Це відоме як латентне навчання: навчання, яке відбувається, але не спостерігається в поведінці, поки не з'явиться причина продемонструвати це.

Ви коли-небудь заблукали в будівлі і не могли знайти свій шлях назад? Хоча це може засмучувати, ви не самотні. У той чи інший час ми всі заблукали в таких місцях, як музей, лікарня чи університетська бібліотека. Щоразу, коли ми їдемо в нове місце, ми будуємо уявне уявлення - або пізнавальну карту - місця розташування, коли щури Толмана будували пізнавальну карту свого лабіринту. Однак деякі будівлі збивають з пантелику, оскільки вони включають багато областей, які виглядають однаково або мають короткі лінії зору. Через це часто важко передбачити, що за кутом, або вирішити, повернути ліворуч чи праворуч, щоб вийти з будівлі. Психолог Лора Карлсон (2010) припускає, що те, що ми розміщуємо на нашій когнітивній карті, може вплинути на наш успіх у навігації по навколишньому середовищу. Вона пропонує звернути увагу на конкретні особливості при вході в будівлю, такі як картина на стіні, фонтан, статуя або ескалатор, додає інформацію до нашої пізнавальної карти, яку можна використовувати пізніше, щоб допомогти знайти вихід із будівлі.